Fridays for future in marcia per "clima, pace e lavoro" con un occhio al voto

28 gennaio 2020

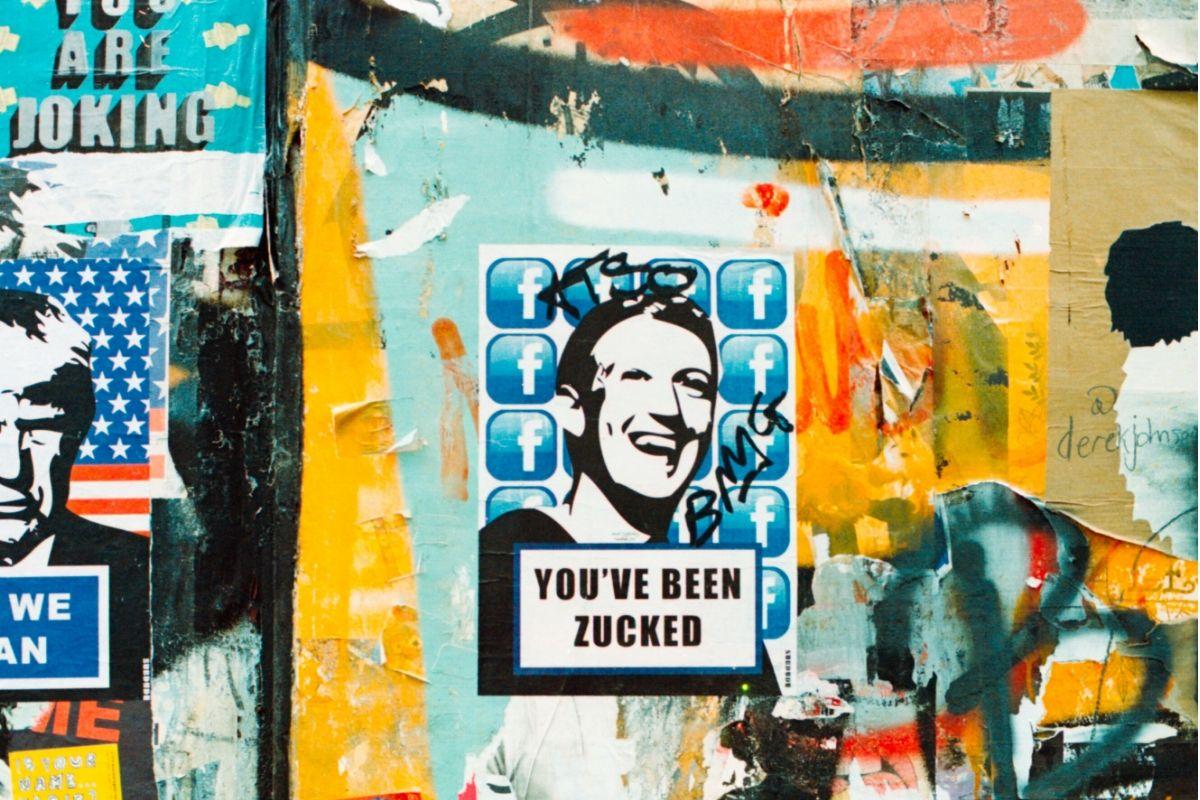

“Il nostro contratto contiene clausole ferree. Non posso rivelare nulla di ciò che faccio, neppure dire che lavoro per Facebook. Se mi licenzio, sono obbligata al silenzio per altri dieci anni”. Marina, nome di fantasia, è una moderatrice di contenuti. Lavora per una società che serve in outsourcing il colosso di Mark Zuckerberg. Secondo la rivista americana The Verge, i moderatori al lavoro per Menlo Park sono circa 15mila, distribuiti in 20 sedi sparse per il mondo. Le strutture che si occupano del mercato italiano si trovano a Barcellona, Dublino e Lisbona, ma “potrebbero essercene altre, a noi non è dato saperlo. Tutto si svolge a comparti stagni”. Marina è la prima moderatrice a rompere il muro di silenzio sul mercato italiano di Facebook e Instagram, rilasciando a lavialibera un’intervista esclusiva, non concordata con l’azienda.

La società di Zuckerberg giustifica la riservatezza assoluta con la necessità di proteggere la privacy degli utenti e l’incolumità dei moderatori, di fatto avvolgendo nel mistero il lavoro di migliaia di persone. I moderatori sono uomini e donne dai 25 ai 40 anni che lavorano su turni di sette, otto o nove ore, giorno e notte. “Ci sono concessi cinque minuti di pausa ogni ora e 20 minuti per mangiare, perché Facebook paga la società sulla quantità di ore che lavoriamo”, racconta Marina.

Gli operai del social visualizzano, approvano o rimuovono quotidianamente milioni di post violenti o raccapriccianti. L’ultimo report di Facebook stima che nel terzo trimestre del 2019 sono stati rimossi 25,2 milioni di post contenenti atti di violenza particolarmente brutali; 11,6 milioni sulla nudità infantile e lo sfruttamento sessuale dei bambini; 7 milioni di incitamento all’odio. Gli effetti psicologici sui moderatori sono pesanti. “Alcuni colleghi si sono licenziati, altri si sono messi in malattia per depressione”.

“L’annuncio indicava una posizione da community manager. Veniva richiesta la conoscenza dell’inglese, qualche nozione di storia e cultura generale sull’Italia, qualche riferimento all’attualità politica. Dopo l’esame scritto abbiamo incontrato uno psicologo cui abbiamo spiegato perché viviamo lontani dall’Italia e dalla nostra famiglia. Le selezioni non sono state particolarmente dure: con me lavorano persone che non sanno chi è Mussolini o Bergoglio”.

“Ne avevo già un’idea, ma solo durante la formazione ho capito fino in fondo di cosa si trattava. Innanzitutto ho imparato una regola che vale sempre: non puoi prendere appunti, non puoi tenere carta e penna, non puoi avere con te il telefono. Pena il licenziamento in tronco. Dobbiamo tenere tutte le informazioni a memoria o consultarle sul momento. Nelle due settimane di formazione abbiamo studiato le linee guida della community e scoperto il tipo di contenuti che avremmo dovuto analizzare: traffico di essere umani, di organi, di animali, violenze di ogni genere, combattimenti di galli, spose bambine, soldati bambini, incitamento all’odio, bullismo”.

“Quando ci sediamo alla nostra postazione accendiamo un programma che attiva una sorta di pagina interna di Facebook dove visualizziamo i contenuti segnalati. Li chiamiamo ticket. Ne visioniamo uno alla volta, decidiamo se rimuoverlo o meno e ne compare un altro. Ne passiamo circa 350-400 al giorno. Per stabilire se rimuovere un post applichiamo meccanicamente le 16 regole della community, a loro volta articolate in sottocategorie costantemente aggiornate. Un esempio: fino ad agosto 2019, tutti i contenuti che inneggiavano a CasaPound potevano essere lasciati online; nel settembre 2019, dopo una lunga procedura, l’associazione politica è stata inserita nella lista delle figure dell’odio e delle organizzazioni pericolose. Si tratta della stessa categoria con cui trattiamo Mussolini e Hitler, le organizzazioni mafiose e personaggi come Totò Riina. Da quel momento ci è stato detto di rimuovere tutti i ticket relativi a CasaPound. Da metà dicembre 2019, quando il Tribunale civile di Roma ha accolto il loro ricorso (in sede cautelare, quindi non definitiva, ndr), ci hanno detto nuovamente di lasciarli online. Non abbiamo possibilità di scelta autonoma: non possiamo rimuovere post che inneggiano a Matteo Messina Denaro perché non è classificato come figura dell’odio”.

“L’algoritmo riconosce le immagini e alcune parole come “troia”, “negro”, “scimmia”. In ogni caso la stragrande maggioranza delle volte le macchine portano a noi le segnalazioni perché siano vagliate e assegnate alle diverse categorie. Un attacco può avere diverse sfumature, essere ironico, usare un’espressione dialettale. La macchina indirizza i ticket in code differenti, sulla base della presunta violazione. Ci sono code prioritarie, come quelle del suicidio e dell’incitamento all’odio”.

“L’odio viene suddiviso secondo tre livelli. Il primo, più grave, tutela sia categorie ‘completamente protette’, ovvero razza, etnia, nazionalità, religione, casta, sesso, genere o identità di genere, disabilità o malattie gravi, sia categorie ‘quasi protette’, come i migranti. I successivi due livelli sull’odio, classificati come meno gravi, riguardano l’inferiorità fisica, morale o mentale, il disgusto, il disprezzo, l’insulto o l’esclusione, e prevedono una violazione solo quando l’attacco è rivolto a categorie completamente protette. Per esempio, non puoi scrivere ‘gli africani mi fanno schifo’, perché la razza è completamente protetta, ma puoi scrivere ‘i migranti mi fanno schifo’, ‘sono stupidi’ o ‘hanno una bassa morale’. È una regola che molti hanno imparato a usare. Abbiamo notato un cambiamento nei post di Giorgia Meloni. Fino a qualche mese fa la buttavamo giù. Poi è arrivato un campanello d’allarme dall’alto, ci hanno detto di essere più morbidi. Infine abbiamo notato che i suoi post hanno cominciato a schivare le nostre policy”.

“Non lo so di preciso. Di certo, noi proteggiamo alcune persone o gruppi considerati ad alto rischio, comei calciatori del Napoli, i giornalisti, i ministri, i membri delle Ong, alcuni giudici, come quelli che hanno emesso la sentenza di condanna per il caso Cucchi. Matteo Salvini è classificato come figura ad alto rischio, perciò lo proteggiamo da tutti gli attacchi. Se sulla pagina delle Sardine qualcuno ha pubblicato dei contenuti contro il leader leghista, e questi sono stati cancellati per violazione, il cumulo di rimozioni potrebbero aver attivato la sospensione automatica della pagina. Sulla base della linea guida violata, una pagina può essere sospesa a causa anche di un solo contenuto”.

“Sono tantissimi i ragazzi che pubblicano foto e video di atti di autolesionismo. Abbiamo code specifiche su questo e sui post che minacciano o millantano la volontà di suicidio. Noi siamo tenuti a prendere decisioni differenti in base alla credibilità del post e alle tempistiche che comunicano. Quando fanno riferimento a un metodo specifico con il quale intendono uccidersi, il contenuto viene scalato perché ritenuto più verosimile. È successo di un ragazzo che ha girato un video in cui minacciava di buttarsi giù da un ponte. In casi come questo è possibile mettersi in contatto con l’utente, scrivendogli direttamente: la procedura attiva anche le forze dell’ordine. Alla fine il ragazzo è stato salvato perché lo hanno raggiunto sul ponte. Un caso simile ha riguardato una ragazza che minacciava di togliersi la vita in 48 ore. Per due giorni l’abbiamo vista postare il conto alla rovescia: ‘mancano poche ore’. La segnalazione è stata girata a chi di competenza, ma non sappiamo che fine abbia fatto”.

“Per fortuna esiste un sistema che ci consente di vedere solo i primi e gli ultimi dieci secondi dei video, anche se il più delle volte, per una strana bizzarria della natura umana, finiamo per sciropparceli tutti per curiosità. A me capita di stare particolarmente male di fronte ai bambini picchiati fortissimo dai genitori o alle violenze sugli animali, ma ognuno ha sensibilità differenti. Vediamo donne drogate, uomini ammazzati, suicidi: molti di questi contenuti arrivano dal mercato sud americano o messicano. Le violazioni commesse dagli italiani riguardano soprattutto l’hate speech: odio a valanga su tutti, in particolare immigrati e rom. Quando arrivo al lavoro, al mattino, mi becco puntualmente decine di uomini che si masturbano a vicenda, soprattutto su Instagram. Ogni tanto ci scappa da ridere, ma sono risate amare. È terribile costatare quanto l’essere umano sia capace di scagliarsi addosso alle disgrazie altrui. Ogni tanto questo lavoro spegne ogni mio desiderio di comunicare con il resto del mondo perché, a furia di sorbirmi questo genere di contenuti, mi pare che tutto il genere umano sia così”.

“Sì, possiamo andare dallo psicologo quando vogliamo, internamente alla struttura. Andiamo praticamente tutti, perché essere esposti così tanto tempo a contenuti sgrammaticati, violenti, gratuiti, ti entra dentro e ti cambia l’umore. Capita che torni a casa e non riesci a liberarti da quel che hai visto. Di notte sogni i ticket che hai trattato”.

“Diversi se ne sono andati, soprattutto per le condizioni di lavoro. Noi non dobbiamo solo decidere se rimuovere o meno un contenuto, ma anche azzeccare la ragione corretta per rimuoverlo. Siamo continuamente valutati da tre policy manager che a campione rivedono i nostri ticket. Ogni settimana abbiamo un margine di errore di uno-due ticket: sotto la soglia del 95 per cento di accuratezza si rischia il posto di lavoro. Questa condizione rende tutto più complicato: sei esposto a contenuti violenti o raccapriccianti e in più vieni valutato sulla qualità di una decisione che devi prendere in pochissimo tempo. A un certo punto ti senti una scimmietta, il cui unico compito è catalogare per ore informazioni sulle nefandezze umane”.

Da lavialibera n° 1 gennaio/febbraio 2020

Crediamo in un giornalismo di servizio ai cittadini, in notizie che non scadono il giorno dopo. Aiutaci a offrire un'informazione di qualità, sostieni lavialibera

La tua donazione ci servirà a mantenere il sito accessibile a tutti

Ambiente, diritti, geopolitica. C'è un nuovo protagonista sulla scena internazionale

La tua donazione ci servirà a mantenere il sito accessibile a tutti